Pride 100 robotov v trgovino. Pogleda vsak 2 banani in se odpravijo ven. Ali boste zaradi njihovega vsakodnevnega obiska nabavili več banan?

Prohibicija piškotkov, ki jo je pred 2 letoma uvedla informacijska pooblaščenka, je imela predvidljiv rezultat. Uporabniki spleta niso nič varnejši, škodovala je statističnim pregledom družbeno odgovornih podjetij. Kazalniki obiskanosti so namreč naenkrat postali precej nejasni in težko je bilo z gotovostjo trditi, kateri spletni oglas nam je prinesel višjo odzivnost.

Zdaj še robotki

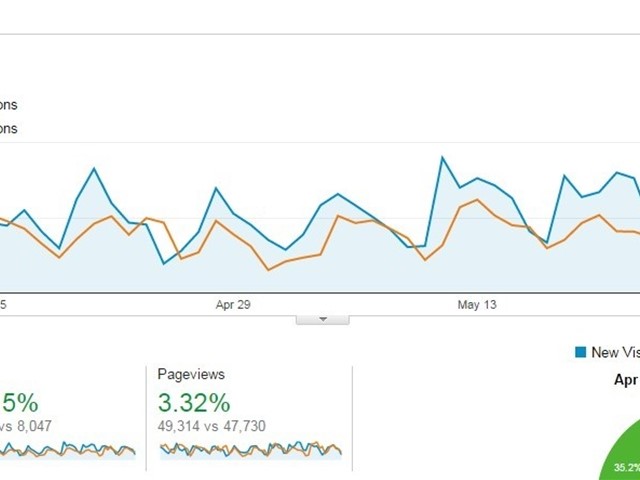

Nekaj mesecev kasneje so na statistiko začeli vplivati spletni roboti prevarantov. Na to smo postali pozorni, ko je v nekaj spletnih straneh, za katere skrbimo, nastalo nenavadno povečanje obiskanosti med 15% in 100% glede na tip strani in dosedanjo obiskanost.

Nekaj mesecev kasneje so na statistiko začeli vplivati spletni roboti prevarantov. Na to smo postali pozorni, ko je v nekaj spletnih straneh, za katere skrbimo, nastalo nenavadno povečanje obiskanosti med 15% in 100% glede na tip strani in dosedanjo obiskanost.

Zaradi nenadnega porasta, za katerega ni bilo vidnega jasnega vzroka (posebne oglaševalske akcije, druge aktivnosti), smo podrobneje pregledali analitiko. Med referrals (napotitvami) smo tako našli strani kot so:

- 100dollars-seo.com

- best-seo-offer.com

- buttons-for-website-com

- ...

Obiski iz teh spletnih strani delujejo kot pravi, a jih dejansko povzročajo spletni roboti - majhni programi, ki simulirajo klike na povezavah spletnih strani.

Namen? Da nepoučeni lastniki spletnih strani obiščejo te portale in tam plačajo za še več obiska.

Preprosta rešitev? Izključimo te vire?

Obstaja nekaj konkretnih predlogov rešitev, kako ta problem omejiti. A pri tem nastane težava, da viri niso stalni.

Obstaja nekaj konkretnih predlogov rešitev, kako ta problem omejiti. A pri tem nastane težava, da viri niso stalni.

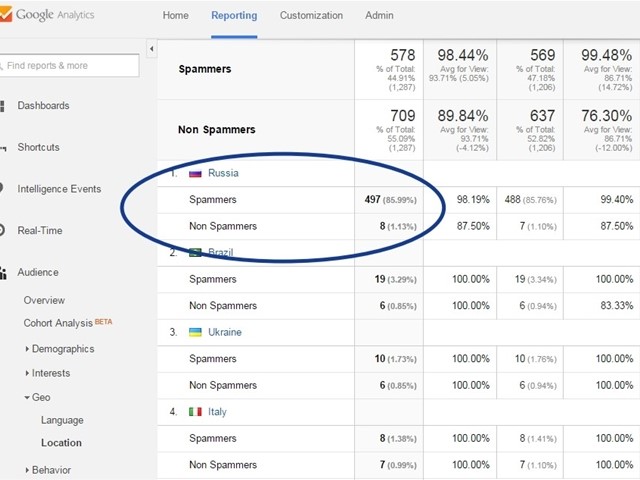

Zanimiva možnost bi bila ustvarjanje filtra glede na državo obiska, saj je pretežen del teh robotov iz Rusije. Vendar seveda to v primeru uspešnega mednarodnega podjetja ne bi bilo smotrno, saj bi s tem omejili dober obisk iz te države.

Model prevarantov se bo najbrž izkazal za uspešnega in se v nadaljevanju razvil v nove variante. Pričakujemo lahko, da bo v naslednjih letih tako seznam prevarantskih domen neskončno dolg iz včasih bo mogoče le ena črka razlikovala pravo domeno od prevarantske. Zato bo vzdrževanje seznamov neveljavnih domen zahtevno.

Če želite, lahko na svoj spletni strežnik namestite rešitev, ki zagotavlja vzdrževanje teh seznamov.

Pojav se v svoji kompleksnosti razrašča in njegovo kompleksnost leta 2017 lahko razberete v tem analitičnem prispevku.

Lahko nas kontaktirate in vam osnovno omejitev v spletni analitiki naredimo mi. :)

Majhna (ali velika) napaka v zbranih podatkov

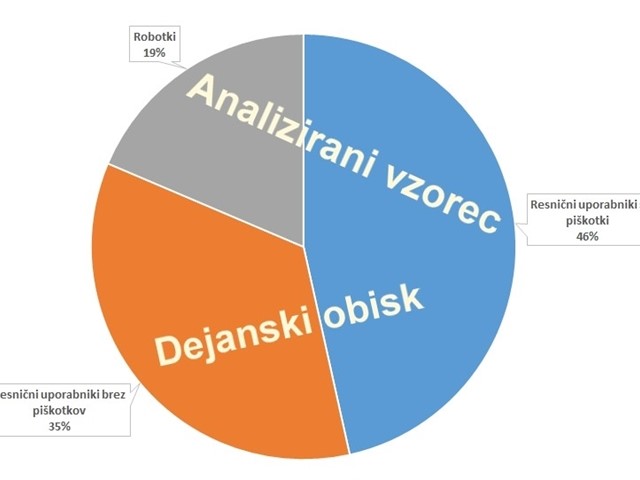

Če imate omogočeno dovoljenje za piškotke in se vaše spletne strani lotijo še prevarantski robotki, je vaša spletna analitika verjetno res precej zmedena. Možnost:

Če imate omogočeno dovoljenje za piškotke in se vaše spletne strani lotijo še prevarantski robotki, je vaša spletna analitika verjetno res precej zmedena. Možnost:

- 35% stvarnih obiskovalcev ni v podatkih (izklopljeni piškotki)

- 46% stvarnih obiskovalcev je v podatkih

- 19% obiskov so roboti

Število ogledov neke podstrani ali klikov na določeno povezavo je tako le približek dejanske slike.

V kolikor nam uspe filtrirati obisk robotov, še vedno ostaja velika težava neznan delež uporabnikov brez piškotkov.

Uporabnost spletne analitike?

A to še ne pomeni, da je analitika neuporabna. S pravilnimi nastavitvami in spremljanjem dogajanja lahko dober spletni skrbnik:

- zmanjša obseg robotov v zajetem vzorcu na raven, ki ne vpliva pomembno na rezultate;

- pripravi preglede podatkov z in brez robotov ter primerja rezultate;

- razume aktivnosti registriranih uporabnikov in predvsem ustrezno pretolmači ugotovitve.

Takšni rezultati bodo relevantni in uporabni. Spletni analitiki lahko nato še vedno zaupamo, vendar je prav zaradi pravilnosti smotrno k sodelovanju povabiti strokovnjake. Da ne boste nabavili preveč banan. :)